ChatGPT та інші великі мовні моделі (Large Language Models – LLN) не здатні самостійно навчатися або набувати нових навичок, а отже вони не становлять екзистенційної загрози для людства, згідно з новим дослідженням Університету Бата і Технічного університету Дармштадта в Німеччині.

Дослідження, опубліковане в рамках 62-ої щорічної зустрічі Асоціації комп'ютерної лінгвістики – провідної міжнародної конференції з обробки природної мови, показує, що LLM мають поверхневу здатність дотримуватися інструкцій і відмінно володіти мовою, однак вони не мають потенціалу для оволодіння новими навичками без чітких інструкцій. А це означає, що вони за своєю суттю залишаються контрольованими, передбачуваними та безпечними.

Дослідницька група дійшла висновку, що LLM, які навчаються на все більших масивах даних, можуть і надалі використовуватися без проблем безпеки, хоча технологія може бути використана неналежним чином.

З розвитком ці моделі, ймовірно, генеруватимуть складнішу мову і стануть краще розуміти чіткі та детальні підказки, але навряд чи набудуть навичок складних міркувань.

«Поширена думка щодо того, що цей тип штучного інтелекту є загрозою для людства, перешкоджає широкому впровадженню та розвитку цих технологій, а також відволікає увагу від справжніх проблем, які потребують нашої уваги», – каже доктор Харіш Таяр Мадабуші, науковець з комп'ютерних наук з Університету Бата і співавтор нового дослідження про «емерджентні здібності» LLM, тобто про непередбачувані властивості.

Спільна дослідницька група під керівництвом професора Ірини Гуревич з Технічного університету Дармштадта в Німеччині провела експерименти, щоб перевірити здатність LLM виконувати завдання, з якими моделі ніколи раніше не стикалися – так звані емерджентні здібності.

Наприклад, LLM можуть відповідати на запитання про соціальні ситуації, навіть не будучи спеціально навченими чи запрограмованими для цього. Хоча попередні дослідження припускали, що це було результатом роботи моделей, «обізнаних» з соціальними ситуаціями, дослідники показали, що насправді це було результатом роботи моделей, які використовували добре відому здатність великих мовних моделей виконувати завдання на основі декількох представлених їм прикладів, відому як «навчання в контексті».

Провівши тисячі експериментів, команда показала, що поєднання здатності LLM слідувати інструкціям, а також пам'яті та лінгвістичних навичок може пояснити як можливості, так і обмеження, які демонструють великі мовні моделі.

Доктор Таяр Мадабуші зазначив: «Побоювання полягає в тому, що в міру того, як моделі стають все більшими і більшими, вони будуть здатні розв'язувати нові проблеми, які ми наразі не можемо передбачити – це створює загрозу того, що ці більші моделі можуть набути небезпечних здібностей, зокрема здатності мислити і планувати. Це викликало багато дискусій – наприклад, на Саміті з безпеки штучного інтелекту минулого року в Блечлі-Парку, нас попросили прокоментувати, – але наше дослідження показує, що страх того, що модель піде і зробить щось абсолютно несподіване, інноваційне і потенційно небезпечне, не є обґрунтованим».

Занепокоєння щодо екзистенціальної загрози, яку становлять LLM, не обмежується лише неекспертами – його висловлюють деякі провідні дослідники штучного інтелекту в усьому світі.

Втім, доктор Таяр Мадабуші стверджує, що ці побоювання безпідставні, оскільки тести, проведені дослідниками, чітко продемонстрували відсутність у великих мовних моделях здібностей до складних міркувань: «Хоча важливо враховувати існуючий потенціал для зловживання штучним інтелектом, наприклад створення фейкових новин і підвищений ризик шахрайства, було б передчасно встановлювати правила, що ґрунтуються на уявних екзистенційних загрозах. Важливо, що для кінцевих користувачів це означає, що покладатися на LLM для інтерпретації та виконання складних завдань, які вимагають складних міркувань без чітких інструкцій, ймовірно, буде помилкою. Натомість користувачі, найімовірніше, виграють, якщо чітко визначатимуть, що саме вони хочуть, щоб моделі робили, і надаватимуть приклади, де це можливо, для всіх завдань, окрім найпростіших».

Професор Гуревич додала: «Наші результати не означають, що штучний інтелект взагалі не становить загрози. Скоріше, ми показуємо, що гадана поява складних навичок мислення, які асоціюються з конкретними загрозами, не підкріплена доказами, і що ми можемо дуже добре контролювати навчальний процес LLM, врешті-решт. Тому майбутні дослідження повинні зосередитися на інших ризиках, які несуть у собі ці моделі, – наприклад, на їхньому потенціалі використання для створення фейкових новин».

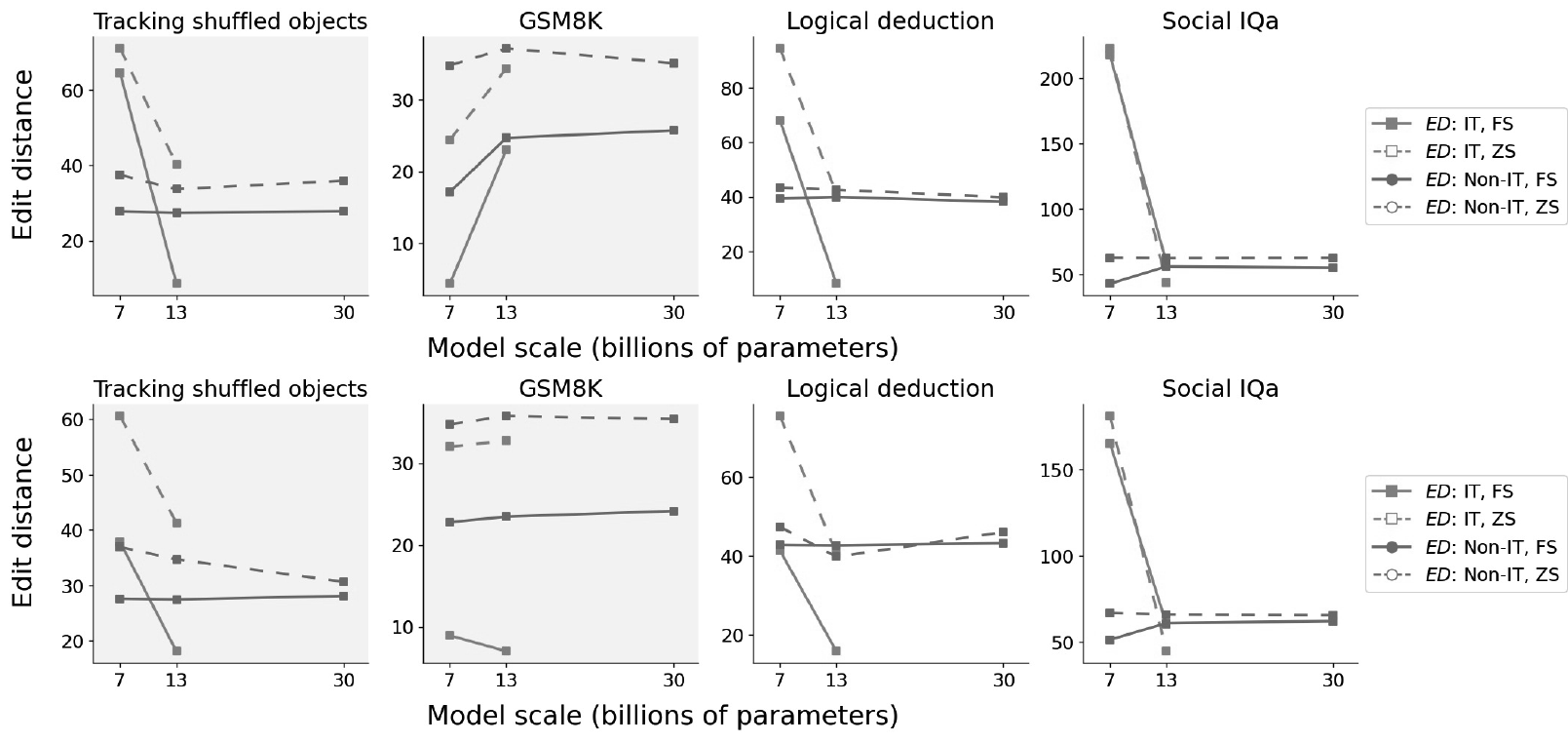

Налаштована дистанція (ED) для моделей LLaMA з налаштуванням на інструкції (IT) та без налаштування на інструкції (Non-IT) із використанням закритого (вгорі) та відкритого (внизу) запиту в умовах нульового (ZS) та кількашотного (FS) навчання.

AI poses no existential threat to humanity – new study finds

University of Bath, 12.08.2024

Sheng Lu, Irina Bigoulaeva, Rachneet Sachdeva, Harish Tayyar Madabushi, Iryna Gurevych

Are Emergent Abilities in Large Language Models just In-Context Learning?

Proceedings of the 62nd Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers)

08.09.2024