Чи живемо ми в комп’ютерній симуляції? Це питання, яке ще двадцять років тому Нік Бостром поставив у філософсько-науковій площині, стало предметом обговорення на черговому засіданні семінару Обрії науки та Львівського наукового товариства.

Із блискучою критикою гіпотези симуляції виступив Franco Vazza, астрофізик з Болонського університету (Італія).

Спираючись на фундаментальні фізичні принципи — голографічний принцип, закони термодинаміки та квантової механіки, — дослідник переконливо довів: моделювання навіть невеликої частини нашого світу з тією точністю, яку вимагає фізика високих енергій, вимагає нереальних обсягів енергії та обчислювальних ресурсів.

Тож хоч як це парадоксально, але саме реалії сучасної науки — найкращий доказ того, що наша реальність не є симуляцією.

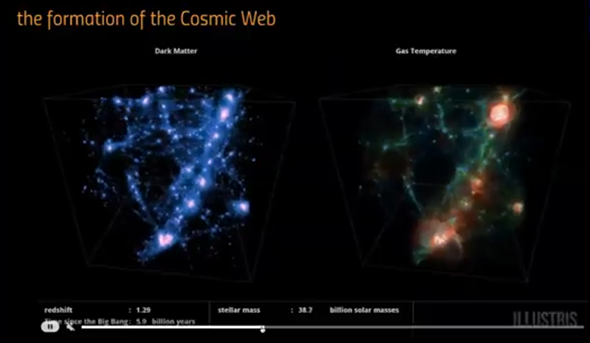

Зазвичай я займаюся «нормальними» – сподіваюся, пристойними – астрофізичними дослідженнями. Я моделюю Всесвіт, космічну павутину, зокрема для того, щоб передбачити, як можуть виглядати магнітні поля, що з’єднують галактики – тобто те, що ми вже бачимо, і те, чого поки що не бачимо, але, можливо, побачимо найближчим часом, наприклад, завдяки великому радіотелескопу Square Kilometer Array.

Це – моя щоденна робота. Також я дуже люблю створювати візуалізації та симуляції, бо вони красиві. Іноді вони навіть потрапляють на обкладинки журналів і наукових статей. Це моя основна «торгова марка». У 2020 році, під час COVID, я написав статтю разом зі своїм другом, нейрохірургом, в якій порівнювали структури людського мозку й космічної павутини – кількісно, з використанням Фур’є-аналізу, статистики мереж тощо. Не впевнений, що з наукової точки зору ця робота така вже вагома, але точно можу сказати, що вона стала вірусною. Принаймні вона варта уваги через те, що вона дала початок нашій співпраці. Саме через неї я зацікавився аналізом мереж у контексті космічної павутини і почав детальніше вивчати цю тему.

У нашій щоденній роботі ми створюємо різні копії того, як міг би виглядати Всесвіт, з використанням математичних методів. В астрофізиці це звичайна практика – створювати цифрові копії Всесвіту у великому масштабі. Ми намагаємось вгадати, яка з таких симульованих моделей найкраще відповідає реальному Всесвіту, спостережуваному через телескоп. А потім намагаємось зрозуміти, які фізичні моделі найбільше схожі на правду.

Деякі з цих варіацій ви навіть не побачили б неозброєним оком, але за допомогою кількісних оцінок ми можемо їх виявити. До речі, цей набір симуляцій має назву Makitra suite, тому що ми намагаємося змішати (як у макітрі) різні інгредієнти, щоб краще зрозуміти, чим є реальність. Десь так виглядає повсякденне життя теоретичного астрофізика.

Отже, ми створюємо симуляції Всесвіту як частину нашої роботи. А чи не може сам Всесвіт бути симуляцією? Це дуже загальне питання. Це не те перше питання, яке я поставив би собі. Але, як ви, можливо, знаєте, це питання з’являється знову і знову в популярній літературі, у медіа. Тож я піднімаю запитання, яке вже належить до царини філософії, бо йдеться про поняття реальності: чи є Всесвіт симуляцією? Принаймні, чи може він нею бути?

А що, коли Всесвіт, у якому ми живемо, – це лише одна з багатьох симуляцій, які створює хтось інший, можливо, одночасно дивлячись на десятки екранів, попиваючи каву і слухаючи музику? А що, як це частина відеогри? Ми вважаємо, що живемо у надскладній реальності, де є квантова механіка, загальна теорія відносності…

А може, це просто правила якоїсь комп’ютерної гри, в яку десь грає підліток? А що, як існує багато копій подібних «земель» або цілих «всесвітів»? Правила можуть бути однакові, але це різні ігри в межах однієї відеогри, різні матчі, так би мовити. Або ж кожна «Земля» має трохи відмінні правила.

А що, коли остаточний симулятор усього цього – навіть не людина? А якась надінтелектуальна сутність, яка керує всім цим?

Якщо прийняти цю гіпотезу хоча б як можливу, то варіанти розвитку думки починають стрімко множитися. Тут немає меж. Якщо те, що ми називаємо реальністю, є симуляцією, тоді немає й кінця можливим рівням симуляцій, які можуть ховатися за кожною нашою сприйнятою «реальністю».

Я почав серйозно над цим розмірковувати торік. Мене запросили виступити в аматорському астрономічному товаристві, з якого я колись починав, коли ще робив CCD-спостереження галактик. Це було близько тридцяти років тому. Вони попросили мене виступити з публічною лекцією. Я хотів зробити її цікавою, не просто за стандартним форматом «Всесвіт великий, галактики красиві». І обрав саме цей напрямок, також тому, що тоді знову з’являлися подібні згадки в літературі.

Іноді хтось із VIP-персон, як-от Ілон Маск (якого я не надто шаную з багатьох причин, і ця – одна з них), одного ранку прокидається і каже: «А раптом ми живемо в симуляції?» – і всі це підхоплюють. Відомі популяризатори науки, як-от Сабіна Госсенфельдер, теж долучаються. Є також справді цікаві міждисциплінарні дебати – наприклад, дебати на меморіальній лекції Айзека Азімова у США 2016 року, де на сцені обговорювали це питання як науковці, так і філософи.

Існує багато серйозних і менш серйозних книжок на цю тему. До серйозних, мабуть, належить праця Девіда Чалмерса. Вона справді захоплива. Звісна річ, що ми маємо згадати також кінематограф.

Ймовірно, кожен із нас бачив цей дуже відомий фільм. Це, звісно, не перша стрічка, яка використовує цю гіпотезу, але вона стала справжнім блокбастером. І зроблена вона, до речі, дуже якісно. Мова про Матрицю. Сподіваюся, я можу розповісти сюжет фільму, якому вже 25 років. Отже, головний герой думає, що живе у звичайній реальності, але насправді ця реальність – симуляція, створена його нащадками. Ми опиняємось у майбутньому, де нащадки симулюють минуле.

Причому вони роблять це не з наукових причин. Вони симулюють минуле переважно для того, щоб чимось зайняти людей. Сценарій такий: це той самий Всесвіт із тими самими законами, планета Земля залишається, але справжня реальність далеко в майбутньому, і майбутнє симулює минуле. Люди під’єднані до машин і не здатні розрізнити реальність, за винятком тих, хто «прокинувся» й вийшов за межі Матриці, – саме вони можуть показати іншим, що таке Матриця насправді.

Матриця – це цифрова структура, набір чисел, що формують симуляцію. Це дуже захопливий спосіб візуалізувати цю ідею, бо в якийсь момент головний герой «пробуджується» і розуміє, що він більше не в тій реальності, яку вважав справжньою.

Філософськи ця ідея була серйозно обґрунтована у науковій статті Ніка Бострома. Не знаю, чи саме через збіг у часі з виходом фільмів Матриця ця стаття стала такою популярною, але, безперечно, вона вплинула на широку аудиторію.

Насправді й до цього були й інші науково-фантастичні книжки та фільми, що використовували цю гіпотезу, але саме Матриця зробила її відомою. А ось ця стаття – та, на яку всі посилаються: Are you living in a computer simulation? (2003).

Це довга й складна праця, у якій також застосовуються статистичні або псевдостатистичні аргументи. Згідно з тезами автора, в майбутньому має реалізуватися один із трьох сценаріїв.

Перший: людство вимре на ранньому етапі, тобто зникне ще до того, як зможе створити надскладні симуляції. У 2003-му це здавалося радикальним, але в 2025-му, з огляду на стан світу, вже не так.

Другий: людство розвиватиметься, але ніхто не буде зацікавлений у створенні складних комп’ютерних симуляцій.

Третій: людство еволюціонує, отримає доступ до надпотужних обчислювальних ресурсів, до енергії, а також зросте наукова зацікавленість. Тоді наші нащадки матимуть майже необмежені потужності для симуляцій реальності, з дедалі вищим рівнем реалізму. І вони створюватимуть нескінченну кількість складних симуляцій.

Їм буде цікаво моделювати власне минуле, і в майбутньому потенційно існуватиме нескінченна кількість симульованих всесвітів. Й ось тут у гру вступає його псевдостатистичне міркування: якщо реалізується третій сценарій, то таких цифрових копій реальності буде безліч. Тоді ймовірність того, що саме ми живемо в єдиній справжній реальності, а не в одній із нескінченних майбутніх симуляцій, дуже мала.

Інакше кажучи, за логікою Бострома, якщо майбутнє дійсно породить незліченну кількість симуляцій минулого, то шанси, що ми живемо саме в «оригіналі», а не в одній із копій, майже нульові.

Отже, згідно з цією гіпотезою, цілком імовірно, що ми вже перебуваємо всередині певної симуляції, створеної нашими нащадками, – так званої ancestor simulation, симуляції предків, у якій вони відтворюють минуле, щоб дослідити, скажімо, історичні закономірності, еволюцію життя тощо. Це дещо тривожний сценарій майбутнього. У ньому існує нескінченна кількість надреалістичних симуляцій, які досягли певного гіпотетичного порогу складності, за яким можуть виникати свідомі цифрові істоти. І ймовірність того, що ми вже всередині однієї з таких симуляцій, дуже висока, бо їхня кількість нескінченна, а «справжня» реальність – лише одна.

Маємо ось таку аргументацію. Не сказав би, що вона надто переконлива, хоча ця ідея теж стала вірусною. Це радше цікава гіпотеза, яка задає напрямок мислення.

Наразі ще ніхто не довів (і є підстави вважати, що це ніколи й не вдасться довести), що можливо створити щось на зразок самосвідомості просто через цифрове представлення. Строго кажучи, кожен із нас знає лише про власну свідомість. Логічно припустити, що й інші люди також свідомі.

Але ще ніхто не показав, що якщо написати дуже складну комп’ютерну програму, то ця програма стане самосвідомою. Можливо, лише потоки електричних імпульсів у нервовій системі, організовані особливим чином, здатні породити свідомість. Ми цього не знаємо. Але в рамках гіпотези симуляції припускається, що якщо змоделювати мозок за допомогою надскладної комп’ютерної програми, то це спричинить появу самосвідомості і така істота в симуляції вважатиме себе реальною.

Ось із цього й починається вся ідея. Вона справді може здаватися вражаючою, навіть шокуючою, і багато людей постійно захоплюються цією гіпотезою.

А тепер, оскільки серед нас, імовірно, не лише астрономи, фізики чи науковці, я зроблю короткий вступ – пояснення, чому симуляції мають таке важливе значення в астрофізиці.

Я сам займаюся чисельним моделюванням, і ми робимо симуляції в астрофізиці, тому що, по суті, не можемо проводити лабораторні експерименти. Іноді ми можемо фіксувати космічні промені, що входять в атмосферу Землі, – це пряме спостереження. Іноді вдається дослідити зразки комет чи метеоритів, які справді прибувають з-за меж Сонячної системи, але це дуже обмежені випадки (максимум – пил з комети чи ще щось подібне). Це рідкісні приклади, коли ми можемо зробити щось на кшталт лабораторного експерименту. Все інше має бути змодельоване. Тобто симуляція означає: ми уявляємо певний сценарій, виходячи з відомих нам фізичних законів, симулюємо результат і перевіряємо, чи він відповідає дійсності.

Сьогодні симуляції надзвичайно поширені в усіх галузях фізики. Наприклад, будь-який прогноз погоди – це теж фізична симуляція: обчислення того, як певна система змінюватиметься в майбутньому. Це сфера гідродинаміки, дуже складної й надзвичайно захопливої науки.

Якщо ви хочете спроєктувати новий літак – вам потрібна чисельна симуляція. Якщо хочете змоделювати, як будівлі реагуватимуть на землетруси, – знову ж таки використовуєте чисельну симуляцію.

Симулюють також, наприклад, що буде, якщо знову вибухне Везувій. За допомогою гідродинаміки вам потрібно змоделювати, як поширюватимуться лавові потоки, щоб зрозуміти, які райони міста варто евакуйовувати, а для яких шансів на виживання немає.

Але у фізиці найчастіше (не завжди, але в більшості випадків) ми намагаємось моделювати майбутнє.

Що буде, якщо я збудую нову будівлю?

Що буде, якщо я створю новий літак?

Якою буде погода завтра?

Що, як завтра вибухне вулкан у сучасному Неаполі?

Натомість в астрофізиці ми намагаємось моделювати минуле. Завдяки телескопам ми можемо бачити Всесвіт навколо нас. Якщо поглиблюємо спостереження, можемо отримати своєрідні знимки минулого розвитку Всесвіту, адже світлу потрібен певний час, щоб дістатися до нас від подій, що сталися в минулому.

Тож те, що ми зазвичай робимо, – це моделювання минулого. Початкові умови – це те, що ми спостерігаємо в нашій Галактиці, у Чумацькому Шляху, або в сусідніх галактиках. Проте ми не знаємо, як усе це сформувалося.

Ми маємо певні уявлення, є гіпотеза Великого вибуху або її варіації, але ми хочемо змоделювати можливу еволюцію Всесвіту в минулому. Звісно, можна симулювати Марс або навіть майбутнє — скажімо, космічну війну. І мені це теж трохи цікаво. Проте якщо я зроблю прогноз, як виглядатиме Всесвіт через мільярд років, чи навіть через тисячу – жоден із нас цього не побачить. Тож, щиро кажучи, з астрофізичної точки зору не так вже й цікаво симулювати те, що ще не сталося.

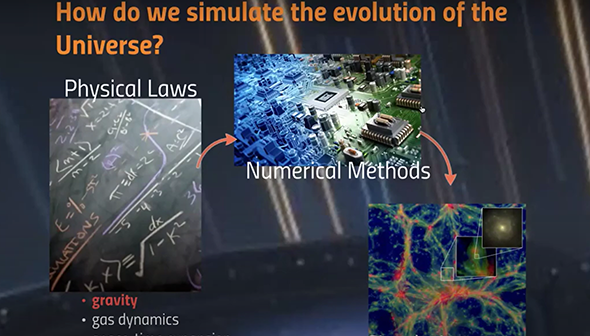

Принцип тут простий, я не буду заглиблюватися в технічні деталі. Ми визначаємо основні фізичні закони. Якщо ви хочете симулювати Всесвіт, скажімо, у космології, то потрібно враховувати:

гравітацію, тобто взаємне притягання матерії,

газодинаміку, адже в більшості Всесвіту речовина існує у вигляді плазми, яка стикається з іншою плазмою та формує складні гідродинамічні явища,

і те, що простір-час розширюється.

Ми формалізуємо ці правила, записуємо їх у вигляді комп’ютерних програм, робимо ці алгоритми якомога ефективнішими й точнішими, використовуємо аналітичні рішення для того, щоб чисельні методи відповідали фізичній реальності. Потім ми поєднуємо ці коди, розв’язуємо рівняння гідродинаміки для кожної окремої клітинки симуляції, запускаємо розрахунки, починаючи з початкових умов.

Ці початкові умови базуються на наших найкращих знаннях про космічне мікрохвильове фонове випромінювання – це стан Всесвіту приблизно через 300 тисяч років після Великого вибуху. Ми задаємо «інгредієнти»: розподіл речовини, темної матерії, темної енергії і запускаємо симуляцію. Далі ми аналізуємо цифрове представлення Всесвіту.

Такі симуляції почали проводити ще в 1970-х роках, тоді – з дуже низькою роздільною здатністю. Навіть вони вже показували те, що ми вважаємо правдою і нині: Всесвіт організований у вигляді мережі, тієї самої, яку ми порівнювали зі структурою людського мозку кілька років тому. Перші симуляції запускалися на комп’ютерах із оперативною пам’яттю лише в кілька кілобайт.

У 1970-х один мегабайт оперативної пам’яті коштував близько 20 000 доларів. Сьогодні в США один мегабайт ОЗП коштує менше одного цента, стільки вже є навіть у простому будильнику. І все ж у 1960-х, маючи всього 32 кілобайти пам’яті, люди могли запустити космічний корабель на Місяць.

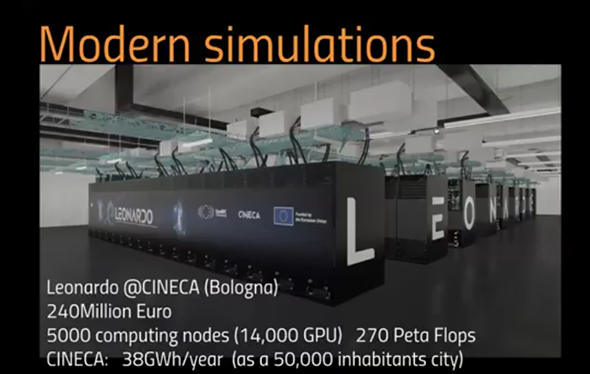

Звісно, обчислювальні можливості зростають дуже швидко. Ось суперкомп’ютер, яким я користуюсь, – він розміщений неподалік від Болоньї і називається Leonardo. У ньому працює близько 50 000 обчислювальних вузлів.

Загалом у ньому понад 13 000 графічних процесорів. Це складна паралельна система, де всі ці комп’ютери працюють разом. І водночас вона споживає велику кількість енергії. Я згадую про це не випадково, бо дуже скоро хочу провести важливий зв’язок між енергією та обчисленнями.

Кожна симуляція споживає енергію. Навіть якщо я просто друкую на клавіатурі та «створюю всесвіти» (у лапках) зі свого ноутбука – десь у пагорбах поблизу Болоньї є машини, які при цьому нагріваються, їм потрібно охолодження, і вони спалюють енергію. Цей комп’ютер Leonardo – один із десяти найпотужніших у Європі.

Щороку він споживає 32 гігават-години енергії, що еквівалентно споживанню невеликого міста з населенням 50 000 людей. Це справді багато. Ми сподіваємося, що ця енергія витрачається на добрі справи.

Наприклад, кілька років тому аналіз даних радарного сканування Середземного моря, проведений за допомогою Leonardo, допоміг відкрити газове родовище поблизу Кіпру. Тобто ви інвестуєте у щось, що споживає дуже багато енергії – наприклад, суперкомп’ютерний центр, і натомість отримуєте можливість дізнатися, де знайти ще більше енергії, як-от нові ресурси в Середземному морі.

Також Leonardo допоміг, зокрема, у проєктуванні вакцини від COVID – це два приклади найбільш видовищних і практично корисних результатів симуляцій за останні роки.

Або, наприклад, симуляція ймовірного формування Місяця. Ми моделюємо минуле: бачимо дві планети, які стикаються. Цей процес займає, вочевидь, кілька століть.

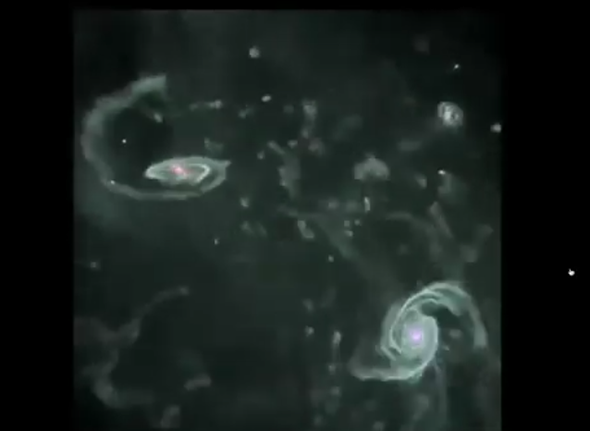

Або ще одна дуже відома симуляція. Вона була проведена в обчислювальному центрі у Швейцарії. Тут моделюється приблизно 10 мільярдів років історії Всесвіту, і ми бачимо, як Чумацький Шлях, імовірно, сформувався через низку злиттів галактик – деякі мали дископодібну форму, інші складнішу структуру. Ви запускаєте симуляцію – вона надзвичайно красива. Вони завжди виглядають гарно, хоча можуть бути й дуже неточними.

Ось, наприклад, буквально в ці тижні триває дискусія: бо якщо ви запускаєте подібну симуляцію й аналізуєте статистику сателітів Чумацького Шляху, то вона не збігається з новітніми спостереженнями, які виявили певну закономірну орієнтацію. Тож зараз учені створюють нові симуляції минулого й перевіряють, чи збігаються вони з реальною картиною, чи ні.

У цій симуляції окремі зорі розрізнити практично неможливо – ми бачимо зоряні скупчення, але не окремі зорі. Але якщо перейти на ще більший масштаб, можна змоделювати, як формувалась космічна павутина. Симуляція охоплює весь вік Всесвіту, «втиснутий» у кілька хвилин. Ви бачите, як формуються нитки та галактичні скупчення і як речовина «впадає» в них упродовж еволюції Всесвіту. Усе на відео світиться рожевим – це означає, що активні ядра галактик викидають матерію назовні й починається формування дуже складних, витончених структур.

Отже, симуляція розвивається, і ми маємо цифрового двійника Всесвіту на певному масштабі. Ми можемо порівнювати його з реальною картиною.

Ось приклад: з одного боку – реальні спостереження, зроблені за допомогою телескопа HST (Габбл), а з іншого – комп’ютерна симуляція з останньої моделі. Яке зображення є справжнім, а яке змодельованим? Візуально це не відрізнити.

Правда в тому, що зліва – реальна світлина, а справа – симуляція. І ці симуляції настільки реалістичні не лише через те, що «виглядають як галактики», а й тому, що вони відтворюють більшість фізичних властивостей галактик. Сьогодні за допомогою таких симуляцій можна навчати алгоритми для виявлення галактик на реальних даних. Отже, симуляції постійно вдосконалюються. Справжні симуляції на Землі (принаймні ті, які ми знаємо) стабільно розвиваються. Вони стають енергоємнішими, але водночас дедалі краще моделюють усе дрібніші структури.

Якщо ви моделюєте весь Всесвіт, то ще п'ятдесят років тому це була двовимірна симуляція, де цілі галактики зводилися до точок. А тепер ми вже можемо розрізнити окремі зорі всередині галактик. Упродовж наступного десятиліття дослідники планують в межах космологічних симуляцій включити моделювання формування планет.

І якщо подивитися на цю прогресію, то вона підказує: з часом ми опускатимемось усе глибше й глибше по рівню деталізації. Ми зможемо краще розуміти всі фізичні процеси. Можливо, колись ми зможемо змоделювати усе, що є у Всесвіті.

А що, як ми самі є частиною симуляції?

Мене зацікавило, чи може фізика допомогти нам «пробити стіну» цієї гіпотези. Бо переважно її представляють оті медійні особи, «віпи» з YouTube та інших майданчиків, як щось неможливе для розрізнення: мовляв, симуляцію неможливо відрізнити від реальності, бо вона може відтворити все, а ми сприймаємо реальність лише через мозок, почуття, враження. А отже, завжди може бути комп’ютер, який це імітує, і неможливо «пробити ілюзію».

Але чи може фізика це зробити? Я вважаю, що так. Ось про це і йдеться у моїй статті. Вона вже прийнята до публікації, буде у відкритому доступі в журналі Frontiers in Physics.

Чи можемо ми використати фізику для перевірки цієї гіпотези? Чи можемо ми справді стверджувати, що всі симуляції однаково можливі, чи ж усе-таки створення певного типу симуляцій підпорядковується фізичним обмеженням – тобто законам, які ми знаємо або принаймні вважаємо істинними?

Парадоксально, але ми вважаємо, що маємо краще розуміння початкового стану Всесвіту, ніж нинішнього. Тому що на початку Всесвіт був дуже простим: це була система, що поводилася майже як ідеальне чорне тіло – приблизно на 300-тисячному році після Великого вибуху. Ми можемо спостерігати цю фазу в мікрохвильовому діапазоні, вона дає нам багато інформації про властивості Всесвіту.

Потім ми, наприклад, застосовуємо до цієї системи закон гравітації – і бачимо, що вона починає колапсувати, формуються зорі, галактики тощо. Але ця частина процесу нелінійна. Тобто навіть якщо ми дуже добре знаємо початкові умови, змоделювати розвиток симуляції так, щоб вона відтворила нинішній Всесвіт, зовсім не просто.

До того ж, у процесі формування зір, їхніх вибухів, виникнення складних молекул тощо виникає додаткова складність, яка накопичується з часом. Навіть виходячи з дуже простих початкових умов, передбачити, як виглядатиме Всесвіт сьогодні, надзвичайно важко. Проте таку вправу можна провести, її проводили безліч разів, і вже завдяки цьому можна відкинути багато моделей, бо вони не дають результату, схожого на те, що ми реально спостерігаємо сьогодні.

Я так розумію: якщо я маю дві дуже схожі симуляції, які обидві дають результат, сумісний із теперішнім станом Всесвіту, то що, якщо в майбутньому ці симуляції почнуть розходитися? Це гарне запитання, тому що нелінійності залишаються, і деякі з них можуть «розкрутитися» саме в майбутньому. Але жоден із нас не буде в змозі це побачити.

Якщо дві різні або дещо відмінні моделі дають однаковий результат зараз, тобто результат, що узгоджується з телескопічними спостереженнями та їхніми похибками, – такі моделі вважаються не відмінними одна від одної.

Можливо, я шукатиму якийсь новий спосіб розрізнення між ними, якийсь додатковий спостережуваний параметр, але не буду спеціально «проганяти» симуляцію вперед у часі, щоб перевірити, як вони розійдуться в майбутньому. Бо якщо вони й відрізнятимуться, то не в межах століть чи навіть тисяч років. Йдеться про десятки мільйонів років, тобто це надто далекий горизонт у майбутнє.

Ми завжди перебуваємо в ситуації, коли можемо ще не знати якогось закону, який справді діє, але виявляє свій ефект лише в майбутньому. Тобто навіть якщо ми можемо дійти до теперішнього стану, ми не знаємо, чи не існує прихованого правила, яке змінить подальший перебіг симуляції. Ми справді обмежені у своєму аналізі минулим і теперішнім. І, на жаль, у астрофізичних масштабах майбутнє для нас недоступне. Проте цілком можливо, що існують фізичні закони, які досі приховані й почнуть проявляти себе лише в майбутньому. Ми не можемо цього виключити.

У певному сенсі темна енергія – дуже фундаментальна концепція, яку ми зараз активно використовуємо, в астрофізиці набуває все більшого значення з часом. Вона стала істотною лише в останні кілька мільярдів років, а в майбутньому, за прогнозами, повністю домінуватиме. І, можливо, різні моделі темної енергії однаково добре описують еволюцію Всесвіту від початку до теперішнього моменту, але в майбутньому вони точно сильно розійдуться. Просто ми не можемо це перевірити.

Саме тому варто докладати зусиль, щоб відкидати хибні теорії, піддавати їх перевірці на основі того, що ми можемо спостерігати на сьогодні.

Отже, ми будемо користуватись двома ключовими поняттями – інформація та енергія. Існує фундаментальна одиниця інформації, яку всі знають, – це біт. Біт – це найелементарніша одиниця вибору або рішення: від 0 до 1, від «так» до «ні». Це найатомарніша форма інформації, яку тільки можна уявити в логіці: так або ні. І вже з цього атомарного визначення інформації можна розгорнути будь-яку цифрову систему. Уся цифрова інформація базується на двійковій системі. Якщо ми об’єднаємо вісім бітів, отримаємо байт.

Запис або зміна біта в будь-якому середовищі потребує енергії. Наприклад, ми можемо закодувати біт як підкидання монетки. Якщо хочемо її перевернути – хтось має витратити енергію. Якщо ми хочемо змінити біт у комп’ютері, нам також потрібно витратити певну, хоч і дуже маленьку, кількість енергії на фізичну операцію. І це фундаментальний зв’язок між інформацією й енергією, встановлений ще в середині XX століття. Тут можна згадати Шеннона, Беннетта, Ландавера – багатьох дослідників.

Ідея така: існує незвідна мінімальна кількість енергії, необхідна для зміни одного біта. Тобто обчислення завжди вимагає енергії. Якщо система працює за певної температури, то мінімальна енергія на одну операцію становить константа Больцмана × температура × log(2). Це фізично обґрунтоване мінімальне значення енергії, яке ми теж враховуватимемо в подальших розрахунках.

А тепер: яка енергетична вартість симуляції?

Наприклад, при температурі 20°C щоб обробити один біт в комп’ютері, потрібно щонайменше 10⁻⁷ ерг – це дуже невелика кількість енергії. Щоб ви зрозуміли масштаб: кінетична енергія звичайної мухи в польоті – це 2 ерг, а цього вистачить, щоб записати цілий мегабайт інформації.

Отже, якщо хтось хоче змоделювати цілий Всесвіт, які для цього будуть вимоги?

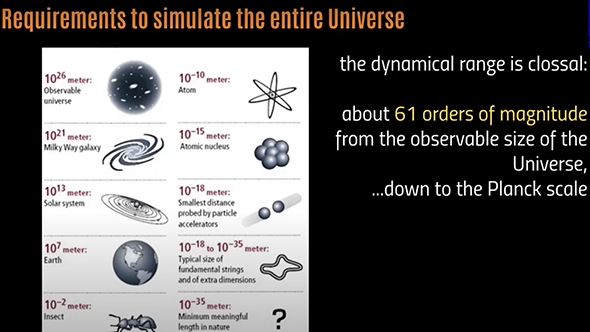

Перше – неймовірний динамічний діапазон.

Потрібно принаймні симулювати весь видимий нам Всесвіт, так званий спостережуваний Всесвіт. Його розмір – це приблизно 2 × 10²⁶ метрів (в радіусі), або ж близько 50 мільярдів світлових років – це та частина Всесвіту, світло з якої встигло досягти нас. Всесвіт може бути нескінченним, але ми маємо справу лише з тією частиною, яку можемо спостерігати. І в цьому Всесвіті існує ієрархія об’єктів, яка охоплює 61 порядок величини – тобто різниця в мільйон мільярдів мільярдів мільярдів мільярдів мільярдів мільярдів разів між найбільшими масштабами й найменшими.

Найменший масштаб у фізиці має назву планківський масштаб. Це найменший уявний розмір, на якому квантова механіка і гравітація, так би мовити, починають мати однаковий вплив. Звісно, я зараз говорю дуже спрощено, але, умовно кажучи, 10⁻³⁵ метра – це найменша довжина, яку ми взагалі можемо собі уявити в фізиці. Це неймовірний динамічний діапазон, який хтось мав би охопити, щоб змоделювати цілий Всесвіт.

Тепер – скільки інформації міститься у Всесвіті? На це питання дати точну відповідь важко, але, на щастя, існує фундаментальний принцип, що походить зі спроб об’єднати теорію струн й квантову гравітацію. І хоча обидві теорії, як на мене, можуть бути й хибними, у процесі їхнього узгодження було відкрито дещо дуже цікаве – більш універсальну властивість, яка випливає із нашого розуміння чорних дір. Якщо ви не астрофізик, чорні діри можуть здатися надзвичайно складними об'єктами. І так, вони складні. Але в фізичному сенсі їхню основну суть можна описати доволі просто.

Усе, що ми знаємо про чорні діри, вказує на те, що існує максимальна кількість інформації, яку чорна діра може містити. Цей висновок формулюється у вигляді голографічного принципу (holographic principle).

Цей принцип можна узагальнити на будь-яку фізичну систему. Ідея полягає в тому, що якщо ми знаємо радіус, який містить об’єкт (припустімо, об’єкт сферичний), а також знаємо енергію, яку він містить, то ми можемо оцінити максимальну кількість інформації, яка може бути у цій системі, згідно з певною формулою. Це і є голографічний принцип, який історично формулювали, зокрема, Герард 'т Гофт і Леонард Саскінд.

Що тут важливо? Наприклад, у випадку з чорною дірою: додавання одного біта інформації до чорної діри – через те, що згідно з теорією відносності енергія еквівалентна масі – спричиняє збільшення маси чорної діри, і це може призвести до її колапсу. Тобто не можна додати більше інформації, ніж дозволяє цей принцип.

Отже, голографічний принцип відповідає на питання: Яка максимальна кількість інформації може бути в межах фізичної системи?

Це, звісно, не висічено в камені, але виглядає як дуже надійне фізичне узагальнення, яке добре узгоджується з тим, що ми знаємо про чорні діри. І найцікавіше: ця кількість інформації зростає не з об’ємом, а з площею поверхні, яка оточує систему. Тобто вона пропорційна квадрату радіуса, а не кубу, що звучить дуже неінтуїтивно.

Чому це називається голографічним принципом? Бо, як і в голограмі, уся інформація, яка описує об’ємний об’єкт, може бути розміщена на площині. Голограма створює ілюзію тривимірного об’єкта, але насправді це просто проєкція інформації на поверхню.

Отже, інформація масштабується з площею, тоді як маса масштабується з об’ємом – це принципово різні речі.

Тепер застосуймо голографічний принцип до всього Всесвіту: яка максимальна кількість інформації може в ньому міститися?

Якщо ми знаємо загальну енергію у Всесвіті (а космологи її або знають, або вважають, що знають) і розмір спостережуваного Всесвіту, то ми можемо оцінити загальну інформаційну ємність. Вона становить приблизно 10¹²⁴ бітів. Ми можемо використати еквівалентність між інформацією та енергією, якщо знаємо середню температуру Всесвіту. І от, щоб просто записати всю цю інформацію десь, нам потрібно 9 × 10¹⁰⁸ ергів – а це, звісно, абсолютно фантастична кількість енергії.

Для порівняння: весь Всесвіт у цілому містить лише близько 10⁷⁸ ергів енергії. Ось у чому суть: для системи з великою кількістю частинок симуляція буде набагато енергозатратнішою, ніж створення самої структури. Щоб записати всі біти, які кодують структуру, потрібно набагато більше енергії, ніж щоб просто мати цю структуру у фізичному сенсі.

Між цим значенням і енергією, яка потрібна для створення цифрового двійника Всесвіту до планківського масштабу, існує різниця в 30 порядків величини.

Голографічний принцип враховує найменший можливий масштаб – планківську довжину, і пов’язану з нею площу, яка відповідає найменшій одиниці ентропії / інформації. Якщо ви хочете змоделювати все до цього найдрібнішого рівня, вам знадобиться величезна кількість інформації. Це і є максимально можлива межа. Навіть якщо ви припустите, що потрібно менше, ви все одно матимете десятки порядків зменшення, перш ніж зможете наблизитися до енергетичних вимог такого рівня симуляції.

Отже, я би сказав просто: моделювання всього Всесвіту неможливе. Це найпростіший висновок. Лише для того, щоб запустити таку симуляцію (навіть не «обчислити» її до кінця!), вам потрібно енергії у 30 порядків більше, ніж є у Всесвіті.

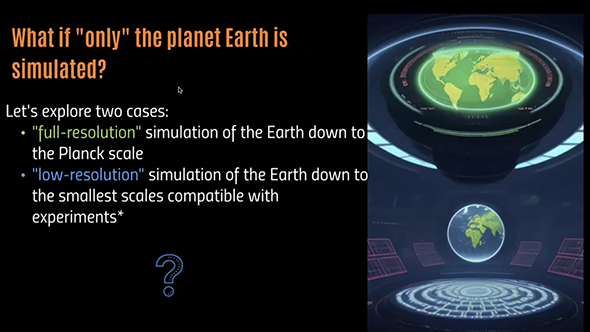

Тепер перейдемо до іншого аспекту. Цікаво гратися в змови, змальовувати різні сценарії. Припустімо, хтось скаже: я не вірю, що весь Всесвіт – симуляція, але, можливо, лише наша планета – симуляція, бо лише через неї ми маємо доступ до реальності.

Можливо, ті кілька астронавтів, які побували на Місяці, теж були частиною симуляції. Або ж симуляція охоплює лише відстань до Місяця – не більше. Розгляньмо два варіанти.

Уся Земля симулюється з максимальною роздільною здатністю, тобто до найменшого можливого масштабу – до планківської довжини. Усе, що знаходиться за межами цього, – це просто тло, умовна "підкладка". На його моделювання йде набагато менше інформації. Воно просто створює ілюзію Всесвіту, щоб астрономи були зайняті, але фізично там нічого немає. Це щось на зразок двовимірної симуляції.

Або ж симуляція відбувається з низькою роздільною здатністю, тобто без деталізації до планківського рівня, якого все одно ще не може досягти жоден сучасний експеримент. Ми просто моделюємо реальність до тієї межі, яка не створює артефактів у фізичних експериментах. Таким чином ми імітуємо Землю, намагаючись зберігати довіру фізиків і астрофізиків, не допускаючи спотворень, які вони змогли б виявити.

Тож розгляньмо спершу випадок максимальної роздільної здатності.

Найпростіше рішення – припустити, що всі фізики, які, власне, й досліджують найменші масштаби, — це негральні персонажі (NPC) у відеогрі. Тобто кожен із них — це цифрова сутність, яка просто «видає» числа, але насправді жодна з них не має свідомості і не здійснює справжніх вимірювань. Але оскільки я сам фізик, хоча й не працюю в галузі фізики високих енергій, я не думаю, що я — NPC :)

Але давайте все ж застосуємо голографічний принцип, щоб порахувати максимальну кількість інформації, необхідну для симуляції лише нашої планети та людей на ній. Якщо обмежити голографічний принцип масою, енергією та розмірами Землі, ми отримаємо приблизно 10⁷⁵ бітів інформації. Навіть якщо ми припустимо, що симуляція працює при мінімально можливій температурі, наприклад, на 1 Кельвін вище абсолютного нуля, це все одно вимагатиме приблизно 10⁵⁹ ергів енергії.

Як виглядає це в астрофізичних масштабах?

Це еквівалентно повному спаленню маси всіх зір у кульовому скупченні, наприклад, як у Palomar 12. Тобто потрібно перетворити всю масу зір на енергію. Або ж — вивільнити гравітаційно пов'язану енергію всієї галактики. І це лише для того, щоб записати симуляцію на диск, ще навіть не починаючи обчислення. А якщо ви хочете запустити симуляцію хоча б на мільйон кроків часу, то вам вже потрібна енергія цілої галактики.

І оскільки цю кількість енергії треба якось зберігати, принаймні в об’ємі чорної діри (яка має максимальну щільність), то для цього потрібен суперкомп’ютер розміром з Юпітер із масою 10⁵ сонячних мас. І вам доведеться «спалити» цю галактичну кількість енергії, щоб отримати хоч трохи адекватну симуляцію – бо ж хочеться симулювати принаймні мільйон часових кроків.

На мою думку, це виглядає абсолютно неправдоподібно. Тобто ви ж не будете спалювати цілу галактику, щоби симулювати нас, правда?

Але добре, спробуймо бути консервативними. Можливо, не вся Земля симулюється з максимальною деталізацією. Може, під земною корою усе у низькій роздільній здатності. (Тут я граю роль адвоката диявола.)

Який найменший масштаб необхідно симулювати, щоб обдурити науковців?

Фізики мають у своєму розпорядженні дуже потужне поняття з квантової механіки – довжину хвилі де Бройля.

Якщо частинка має певний імпульс або енергію, то їй відповідає певна довжина хвилі. Отже, якщо частинка з такою енергією проходить крізь Землю, симуляція повинна мати щонайменше такий рівень роздільності, інакше виникатимуть артефакти – тобто частинка не буде поводитися так, як ми очікуємо на основі експериментів.

Візьмімо, наприклад, прискорювач частинок, як-от Великий адронний колайдер у Женеві, який дає енергії порядку 10¹³ електронвольт. Це відповідає дуже малій довжині хвилі – близько 10⁻¹⁶ сантиметра. Але з космосу прилітають ще енергійніші частинки – ультрависокоенергетичні космічні промені. Їхня довжина хвилі ще менша, приблизно 10⁻²⁴ сантиметра. Це все ще далеко від планківської довжини (10⁻³⁵ см), але все одно надзвичайно малий масштаб.

Отже, симулятор має симулювати все принаймні до цього рівня деталізації, якщо хоче уникнути виявлення. От така була моя логіка. Я використав космічні промені, зокрема тому, що єдина серйозна астрофізична стаття, яка реально займалася цією темою, була опублікована ще у 2014 році: Constraint on the Universe as a numerical simulation.

У ній також розглядалися ультрависокоенергетичні космічні промені, але – на позагалактичних відстанях. Автори тієї статті не надто захоплювалися змовами: вони все ще вважали, що існує фізичний космос, через який ці промені поширюються.

Їхній аргумент був таким: якщо симуляція має набагато грубшу роздільність, ніж довжина хвилі де Бройля цих частинок, то їхнє поширення через решітку симуляції мало би спричиняти ефект аліасингу (aliasing) на небі. Кожен, хто працював із чисельними симуляціями, знає, що можна отримати числові артефакти вздовж певних напрямів, зокрема вздовж координатних осей симуляції. Якщо розв’язувати потоки по осях або по діагоналях, можна отримати хибні закономірності – саме це і є аліасинг.

Однак ультраенергетичні космічні промені, які ми реєструємо, мають ізотропний розподіл – тобто приходять рівномірно з усіх напрямів. І саме тому, що жодного ефекту аліасингу не спостерігалося, автори тієї статті дійшли висновку: якщо симуляція й існує, то вона має бути принаймні детальнішою, ніж цей масштаб.

Але я, скажу чесно, налаштований більш змовницьки – бо це просто гра, яка приносить задоволення. Припустімо: увесь Всесвіт поза межами Землі – це симуляція.

Астрономи постійно дивляться на екран, а не на справжній космос. А всередині Землі, скажімо, усе порожнисте або дуже низької роздільності. Бо ж ті частинки (космічні промені) летять із неба й поглинаються поверхнею планети. А яка там роздільність усередині, ми не знаємо. Жоден вимір ще не сягав таких дрібних масштабів у надрах Землі. Сучасні методи геофізики дозволяють «заглянути» максимум на сотні метрів углиб, а ми тут говоримо про частки сантиметра.

Але, на щастя, нас рятують інші частинки – високоенергетичні нейтрино.

Це надзвичайно швидкі частинки, які дуже слабо взаємодіють з речовиною. І ми знаємо, що вони перетинають нашу планету, бо один із детекторів – IceCube, розташований на Південному полюсі, фіксує нейтрино, які проходять крізь Землю.

Нещодавно також було зафіксовано надвисокоенергетичне нейтрино, яке летіло майже паралельно до поверхні моря. Воно не пройшло крізь планету, але решта – так.

Тобто ми маємо прямі докази того, що реально існують частинки, які пролітають крізь Землю – і, відповідно, симуляція повинна мати досить високу роздільність навіть усередині планети, щоб це симулювати без артефактів. Планета мусить бути змодельована, інакше нейтрино поводитимуться інакше, ніж ми це спостерігаємо.

Тепер повернімося до логіки. Як порахувати нову вимогу до обсягу пам’яті?

Моя пропозиція така: замість планківської довжини ми використовуємо довжину хвилі нейтрино як новий мінімальний масштаб. Тобто, симуляція будується за тією ж логікою, як і раніше (тобто за голографічним принципом), але із заміною ключового масштабу: ми вже не вимагаємо деталізації до планківського рівня, нас влаштовує грубіша роздільність.

Якщо ми відповідно перемаштабуємо формули і оновлюємо обчислення, то отримаємо:

Інформаційна ємність: 10⁵¹ бітів

Енергія, необхідна, щоб записати цю інформацію на диск: 10³⁵ ергів

Це вже значно керованіший масштаб. Це приблизно енергія, яку Сонце випромінює за дві хвилини. Звісно, для нас це колосальна кількість, але уявімо, що через тисячу років якась цивілізація зможе побудувати щось на кшталт Сфери Дайсона, яка повністю захоплює енергію зорі. У такому випадку це вже не звучить так шалено, як попередні сценарії.

Ця енергія потрібна лише для того, щоб «записати» дані про симуляцію Землі з низькою роздільністю. Але чи означає це, що гіпотеза симуляції в низькій роздільності — можлива? Я би не поспішав із таким висновком.

Наприклад, Сет Ллойд ще у 2000 році обрахував максимальну кількість операцій, яку можна виконати над одним бітом при заданій енергії. Це стосується квантової механіки, бо в ній енергія визначає частоту (обернену до часу), тобто як швидко можна змінювати стан біта.

Якщо ви хочете це робити в системі, яка здатна утримати стільки енергії, скільки потрібно для симуляції Землі, то максимально компактною системою буде чорна діра. У цьому випадку – надзвичайно маленька чорна діра, розміром 10⁻⁷ см. Така чорна діра може обробляти 10⁶⁷–10⁶⁸ байтів на секунду, що, безперечно, величезна швидкість обчислень.

Але! Якщо застосувати цю швидкість до загального обсягу пам’яті, який потрібно обробляти безперервно, то стає зрозуміло, що:

щоб симулювати навіть одну секунду нашого часу, система має виконати 10³² операцій на кожен біт, оскільки це масштаб часу, з яким пов’язане поширення нейтрино — 10⁻³² секунди.

У результаті, навіть при такій гігантській обчислювальній потужності, чорній дірі знадобиться 10 мільйонів років, щоб просимулювати одну секунду симуляції Землі в низькій роздільності. І це — забагато.

Хто готовий витратити 10 мільйонів років, щоб просимулювати одну секунду життя нашої планети?

Можна уявити, що хтось таки прискорить цей процес. Але тоді потрібно пришвидшити обчислення у 10¹⁷ разів, щоб симуляція відбувалась у реальному часі – тобто одна секунда симуляції відповідала б одній секунді обчислення. Але якщо ви це пришвидшите, то виникає нова проблема: тепер вам потрібно величезну кількість енергії – 10⁷³–10⁷⁵ ергів за секунду.

Це потужність, яку випромінюють надмасивні чорні діри під час злиття. А це злиття відбувається один раз за всю історію існування галактики. А ви, натомість, маєте витрачати таку енергію щосекунди, щоб симулювати планету. Це абсолютне безумство.

Якщо застосовувати до цього фізику – принаймні так, як її застосовую я (хоча це дискусійно), – то виходить, що ми потребуємо гігантські або навіть неможливі обсяги енергії, щоб навіть просто запустити симуляцію або просимулювати хоча б одну секунду. Неможливі – означає, що вони взагалі виходять за межі енергетичного бюджету нашого Всесвіту. Гігантські – означає, що треба спалювати цілу галактику щосекунди, і ніхто цього не робитиме. До речі, навіть просто «пересунути» енергію в масштабах галактики – це мільярди років, бо галактики не перетинаються за секунду.

Обмежень настільки багато, що це не має жодного фізичного сенсу.

Тож мій висновок:

Неможливо, що весь Всесвіт є симуляцією.

Неможливо, щоб навіть Земля була симульована – навіть у низькій роздільності.

Бо фізика постійно досліджує малі масштаби, і ми знаємо, що ці масштаби існують. І якщо вони існують у симуляції, то їх відтворення потребує не просто колосальних – а буквально нереалізованих енергетичних ресурсів.

Але є один цікавий вихід.

А що, як фізичні константи в «реальному» Всесвіті, де запущена симуляція, – інші?

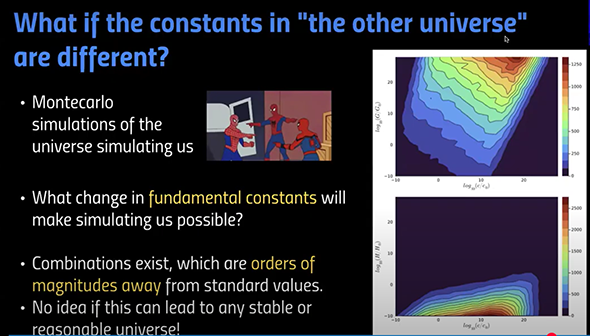

Тобто ми вже не говоримо про симуляцію нашими нащадками. Ми питаємо: а що, як наш Всесвіт є симуляцією в іншому Всесвіті, який працює за схожими, але не тими самими законами фізики? Може, там інша гравітаційна стала, інша планківська стала тощо. Я грався з цією ідеєю в своїй статті. Було цікаво, бо я створив набір симуляцій методом Монте-Карло, в яких, умовно кажучи, цей симульований Всесвіт сам симулює, яким міг би бути справжній Всесвіт. Це такий божевільний логічний цикл, але цікаво. Я просто «грався» з фундаментальними константами і намагався знайти комбінацію, яка б зробила симуляцію реалістичною з точки зору голографічного принципу й дозволила би її запустити в реальному часі.

І справді, можна підібрати комбінації фізичних констант, за яких симуляція нашого Всесвіту теоретично могла б бути здійсненою. Наприклад, якщо стала Габбла була б на 10 порядків меншою, або швидкість світла більшою, або гравітаційна стала Н'ютона вищою – можна знайти комбінації, за яких можна було б змоделювати такий Всесвіт.

Але чи дає така гра з константами фізично осмислений Всесвіт, поняття не маю.

Це радше була гра, певна інтелектуальна вправа.

Інша можлива реакція – це, власне, початкова ідея Рене Декарта: єдина річ, у якій ви можете бути абсолютно впевнені – це те, що ви свідомі, бо ви мислите: Cogito, ergo sum

Твердження, яке дуже важко або й узагалі неможливо спростувати, – це те, що ваш мозок, ваша діяльність симульовані комп’ютером. Бо симуляція людського мозку на рівні чисел – це величезний виклик, але, можливо, виклик, який людство вирішить у наступному столітті. Для цього потрібно приблизно 10¹² бітів пам’яті і, ймовірно, до 10²⁴ операцій з плаваючою комою на секунду. Це масштаби майбутнього, але не абсолютно неможливі.

Отже, симулювати один мозок можливо.

Але як симулювати один мозок або кілька так, щоб реальність, яку ці мозки сприймають, була узгодженою, – це вже інша проблема.

Я би стверджував, що якщо ви хочете симулювати багатьох людей, які обмінюються інформацією про фізичні явища, спостереження, вимірювання, вам все одно доведеться симулювати фон, який забезпечує послідовну реальність. А це вже майже повноцінна симуляція всієї планети.

Якщо ви симулюєте лише одного індивіда, і ця людина не є тією, хто міряє довжину хвилі нейтрино, її обдурити простіше. Але втекти від цієї «ілюзії» все одно дуже важко.

Або ще один жартівливий варіант – сценарій з Pac-Man’ом.

Уявіть, що всесвіт, який нас симулює, повністю відмінний від нашого. Уявіть, що одна з істот у грі Pac-Man почала розмірковувати про Всесвіт, який її симулює. Це було б надзвичайно складно, бо вона живе в двовимірному світі, не знає про існування гравітації, про фізичні константи тощо. Їй надзвичайно важко вийти за межі своєї коробки.

І якщо наш Всесвіт є симуляцією, запущеною в іншому всесвіті з зовсім іншими законами, то дуже складно, використовуючи наші фізичні закони, зробити висновки про той «вищий» всесвіт.

У Pac-Man’а енергія вимірюється не в джоулях, а в power pellets або полуничках :)

Отже, мій загальний висновок:

Розмірковувати над гіпотезою симуляції цікаво, бо це не просто фантазія – це питання, яке можна досліджувати за допомогою фізичних законів.

Але якщо ми говоримо про гіпотезу ancestor simulation – тобто симуляцію, запущену нашими нащадками у цьому ж Всесвіті, – то вони повинні підкорятися тим самим законам фізики. І я вважаю, що можна довести: така симуляція неможлива.

А якщо ми є частиною симуляції, запущеної в іншому Всесвіті з іншими законами – тоді, можливо, ми й не зможемо це виявити. Але все ж можна шукати артефакти. Бо всі симуляції, які створюють люди, мають артефакти. І поки що немає жодної причини вважати, що симуляція не матиме артефактів. Саме тому деякі дослідники шукають артефакти в природі, у закономірностях, у спостереженнях.

Або ж – варіант найпростіший:

Ми просто не живемо в симуляції. І реальність – це реальність.

Текст підготував Андрій Гриниха

04.06.2025