Я назвала свою доповідь «Наука маленька, наука велика», і присвячена вона наукометричним питанням.

Вісім років тому, коли я захищала свою кандидатську дисертацію, також присвячену одній з наукометричних проблем, цей термін радше дивував – наукометрія. Відчувалося, що він сприймається як щось «притягнуте за вуха». Натомість сьогодні цим нікого не здивуєш – зокрема, для тих, що працюють у науці, стали звичними поняття «наукометрія», «бібліометрія», індекси цитування, h-індекси тощо. За останні десять років популярність наукометрії зросла. Цей термін часто приходить «згори», коли оновлюються вимоги до наукових дисертацій, звітів тощо.

Якщо ввести в Google Scholar українською мовою запит «наукометрія», побачимо, як кожні десять років, починаючи з 60-их років ХХ століття, коли почався бурхливий розвиток відповідних досліджень, зростала кількість публікацій, у яких траплявся термін «наукометрія». За останні сім років йдеться про 1320 статей, тоді як на початку їх знаходимо всього-на-всього три. На підставі таких даних можна дійти висновків про те, як термін ставав популярним. Не останню роль у цьому відіграла прив'язка наукометрії до оцінювання в науці. Забігаючи наперед, скажу, що наукометрія – набагато ширша царина, вона існувала й до того, як її пов'язали саме з оцінюванням. Більше того, ті методи та підходи, які широко використовують, насправді не заточувалися під задачі оцінювання. Нині наукометрія та оцінювання дуже тісно пов'язані, проте розвиток одноіменного напряму науки починався з іншого.

Отже, як оцінити науку і чи потрібно це робити? Для того, щоб щось оцінити, потрібно розуміти сам процес. Що ж означає «займатися наукою»? Роздумуючи над відповіддю на це запитання, кожен знаходить свою відповідь. Напевно, хтось скаже: основна мета науковця – досліджувати світ і місце людини у ньому, щоб отримати нове знання. Хтось наголосить: «корисне знання», а хтось заперечить, що корисність – річ відносна. Щось може мати прикладне значення негайно і навіть виражатися в гривневому еквіваленті. Однак певні речі виявляються необхідною цеглинкою важливого відкриття через сто-двісті років. Навіть помилкові твердження та відкриття, негативні результати – не є «поганими». Ми не можемо сказати, що для науки вони не мають цінності, позаяк пошук істини, чим займаються науковці, є нерозривно пов'язаний зі спробами та помилками. Часто саме помилковий результат може бути необхідною сходинкою на шляху до віднайдення правильної відповіді.

Ще Айнштайн казав, що наука – це прекрасна річ, якщо нею не потрібно заробляти на життя. Всі ми залежимо від матеріальних цінностей: комусь потрібно заробляти на аркуш паперу, комусь – на прискорювач частинок. А там, де є інвестування чи оплата праці, там повинна бути звітність та хоча б частковий контроль результату. З огляду на це необхідним стає оцінювання і процесів у науці.

Проте як оцінити продукт наукової праці, якщо його неможливо виміряти лінійкою чи роздивитися на власні очі? Часто наукову діяльність порівнюють із творчістю, з мистецтвом. Схожі риси є. Скажімо, як оцінюють картину? Передусім висловлюють свою думку фахівці, художні критики. Також важлива опінія спільноти, чия прихильність і робить художника знаменитим. Щось подібне відбувається в науці. Єдина різниця полягає в тому, що тут експертами-критиками є ті ж науковці, яких і самих критикують. Ми критикуємо, і критикують нас. Англійський термін «peer-review» ідеально годиться, щоб описати цей процес. Він позначає рівноправність, тоді як вітчизняні терміни «рецензування», «експертне оцінювання» передбачають відмінність ролей, у певній мірі ієрархію. А «peer review» означає, що мене оцінює хтось рівний мені, відбувається взаємне самооцінювання. І цей принцип – самооцінювання – насправді лежить в основі будь-якого оцінювання в науці: рецензування статей, культури захисту дисертаційних робіт чи розрахунку індексів на основі наукових цитувань, що є формою визнання результатів одне одного.

Для реалізації принципу самооцінювання необхідною умовою є обмін знаннями та результатами, комунікація. З часом форми наукової комунікації, та й сама культура наукової праці, змінювалися – а з ними еволюціонували і методи їхнього оцінювання. Спочатку людей, що намагалися раціонально пізнати світ і називалися філософами, було небагато. Далі кількість науковців почала зростати. Можливість особистого контакту замінялася іншою популярною формою спілкування – листуванням (вивчають досі переписки Айнштайна, Фройда, Дарвіна). Тоді це був спосіб обмінятися науковою інформацією, здійснити той механізм самооцінювання, про який мовилося вище. Проте коли вчених стало ще більше, з'явилася потреба в ефективніших методах представлення та оприлюднення наукового результату. Так з’явилася наукова періодика.

Сьогодні наукова праця невіддільна від публікації її результатів. Проте так було не завжди. Прикладом цьому є Роберт Гук. У 60-х рр. XVII століття він опублікував свій відомий закон у вигляді анаграми – фрази «яка напруга, така й сила», написаної латиною. Для чого це було? По-перше, щоб дочасно «не розкривати карт» і самому працювати в окресленій перспективі, отримати нові здобутки – тут спрацював людський чинник, який часом гальмує і науку. А по-друге, так зберігалася можливість при потребі задекларувати своє авторство, просто розшифрувавши оприлюднену анаграму. І цей випадок не єдиний. Є свідчення, що і Ньютон не поспішав публікувати свої результати, і Ляйбніц. Неодноразово в історії науки виникали суперечки за першість результату. Відомо, що дві третіх усіх відкриттів того часу перевідкривалися. Тобто культура наукової роботи була принципово іншою.

Розвиток наукометрії. .

Цікаво, що вже через якихось п'ять років після 1660-го були засновані перші періодичні видання – в Парижі та Лондоні. Майже одразу виникли і реферативні журнали з інформацією про опубліковані роботи та місце, де їх можна знайти.

Саме тоді почали закладатися підвалини відомого нині вислову «publish or perish» («публікуйся або зникни»). Так, з’являється нове розуміння захисту інформації, що полягає не у її приховуванні, а в якомога швидшому оприлюдненні. А приблизно через 200 років Фарадей вже казав своєму учневі: «Працюй, завершуй, публікуй». Тобто публікація результату стала невід'ємною ланкою діяльності науковця.

Основним завданням редакторів перших періодичних видань було наповнення номера для публікації. З часом, з огляду на збільшення кількості науковців і наукової інформації, ті самі редактори мусили вже «відбиватися» від надмірної кількості охочих опублікувати рукописи. Тоді ще не існувало поняття рецензування як «вхідного фільтра наукової інформації». Аж до середини ХХ століття воно не було офіційно прийнятим у більшості наукових видань, хоча практикувалося задовго до цього. Наприклад, лише 1938 року рецензування остаточно запровадили в популярному журналі «Science», а ще пізніше, у 1967 році, – у «Nature».

І хоча нині процедуру рецензування статей вважають чимось очевидним, менше ніж сто років тому (1936 року) Айнштайн її абсолютно не сприйняв. Коли він отримав зауваження незалежного експерта до надісланої в журнал статті (це була одна з перших відомих рецензій), то був страшенно обурений. Відомий вчений не розумів, як можна було показати його ще не опублікований доробок третій особі. В результаті Айнштайн вирішив відмовитись від публікації матеріалу у цьому виданні.

Минуло не так багато років – і ми не уявляємо наукового життя без рецензування та публікації статей. Очевидно, що більшість змін спричинив фактор збільшення кількості наукової інформації. Ще в 40-их рр. ХХ століття один з батьків наукометрії Дерек Джон де Солла Прайс виявив, що кількість наукової інформації зростає за експоненційним законом. Щоб зрозуміти критичність ситуації, варто згадати індійську легенду про винахідника шахів. Згідно із нею, у винагороду за чудову гру він забажав стільки рису, скільки поміщається на шаховій дошці: на першій клітинці – одна рисинка, на другій – дві, на третій і четвертій – 4 та 8, і так далі. Тобто на кожну клітинку мало припасти удвічі більше рису, ніж на попередню. Згодом виявилося, що загаданої кількості рису вистачило б, щоб рівномірним шаром покрити земну поверхню включно з океанами двічі.

Таким чином, можна собі уявити, про які закономірності зростання у науці говорив Солла де Прайс. Вважаючи кількість публікацій, що зростає, непрямим індикатором збільшення популяції науковців – учений стверджував, що кожні 15 років їх стає приблизно вдвічі більше. Оскільки таке збільшення не може відбуватися безкінечно, той же Солла де Прайс передбачив, що до 1961 року відбудеться перенасичення і тенденція піде на спад.

Ці прогнози не справдилися. Результати досліджень, здійснених ще три роки тому, засвідчують: експоненційне зростання продовжується. І нині кожні 9-12 років кількість наукових журналів подвоюється. Передусім це можна пояснити тим, що ми перейшли з паперової форми публікацій на електронну. Окрім того, кількість публікацій нині вважають одним із показників продуктивності вченого, що заохочує публікувати все більше.

Відомий вислів Солла де Прайса: «80-90 % вчених, які коли-небудь ходили по землі, є нашими сучасниками». Минуло більш як півсторіччя, а твердження залишається актуальним як ніколи.

Черговий скачок у розвитку науки відбувся після Другої світової війни. Вона стала каталізатором того, що держави почали цікавитися науковими розробками та вкладати у них гроші. Зростання обсягів наукової інформації поступово набуло рис лавини. У 50-60-ті роки ХХ століття світ «захлинається інформацією»: її не мають фізичної змоги адекватно опрацювати самі науковці; бібліотеки та архіви не знають, як ефективно укомплектувати свої фонди; видавці стикаються із все гострішою проблемою відбору з-поміж надісланих рукописів.

До слова, кількість відхилених рукописів є одним із пунктів, яким цікавляться і сьогодні, оцінюючи наукове видання. Наприклад, 2013 року журнал «Nature» оприлюднив власну статистику, згідно з якою лише 8 % із надісланих статей публікують на його сторінках. Більшість із рукописів відхиляють вже на етапі редакторського відбору, і вони навіть не потрапляють до рецензента.

У той же час розуміння того, що опрацювати весь інформаційний масив є неможливо, визріли, і теоретичні аргументи на користь того, що розумний відбір має бути. Було виявлено таку закономірність: всі наукові статті, знайдені за заданим тематичним пошуком, розподілені між науковими виданнями дуже неоднорідно. Третина усіх знайдених матеріалів завжди буде концентровано міститися у невеликій кількості журналів. Ще одна третина статей розсіяна серед суттєво більшої кількості видань. І решта статей можуть бути знайдені при опрацюванні решти багаточисельної наукової періодики. Самуель Бредфорд, чиїм ім’ям і названо відповідний закон, вирахував пропорцію кількості видань, що належать до кожної із цих трьох категорій: 1:n:n2. Тобто опрацювання невеликої кількості джерел дає змогу отримати третину необхідної тематичної інформації. Ефективність подальшого пошуку є значно нижчою.

Цей закон теоретично обґрунтовує, що ефективний інформаційний пошук має бути цілеспрямованим та передбачати наявність відбору. Саме цим керуються авторитетні нині наукометричні сервіси Web of Science (WoS) і Scopus. Адже вони не претендують на всеохопність, скрупульозно відбираючи матеріал для індексування у своїх базах.

Інформаційна лавина 60-х років та нагальна потреба вироблення алгоритмів пошуку і фільтрації наукових джерел привели до нового витка у розвитку наукометрії. Озброївшись попередніми теоретичними напрацюваннями в області кількісного аналізу науки, бібліометричними даними та сучасними методами їхнього опрацювання, наукометрія починає формуватись у самостійний науковий напрям.

Аби перейти безпосередньо до означень наукометрії, потрібно звернутися до її історії. Тоді як у світі оперують переважно одним терміном – «scientometrics», на теренах колишнього Радянського Союзу співіснують два: «наукознавство» і «наукометрія», що мають дещо різні значення. Наукознавство – це «наука про науку» – всеохопний напрям, що вивчає всі аспекти науки, зокрема її історію, філософію, психологію, культуру тощо. Натомість наукометрія – первинно будучи піднапрямом наукознавства – займається всім, чим займається наукознавство та що має кількісний вимір, що можна представити у вигляді чисел, графіків, таблиць тощо.

Видається, що деякі аспекти на кшталт історії чи філософії науки залишають поза межами наукометричних розвідок. Однак нині все більше гуманітарних дисциплін починають ефективно використовувати кількісні методи, вводячи все більше математики. Сьогодні існує кількісна лінгвістика, активно використовують статистику та методи моделювання у психології та соціології тощо. Відповідно, область наукометрії також розширюється. Наукометрія займається аналізом структури науки, динаміки її розвитку, досліджує виникнення нових тематик чи закономірності утворення наукових груп тощо. Тож наукометрія займається далеко не лише оцінюванням.

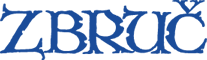

Ще у 20-их рр. ХХ століття вивели один із перших кількісних законів розвитку науки (закон Лотки), який описує співвідношення між кількістю публікацій та кількістю науковців. Його степенева форма говорить про те, що багато вчених публікують мало статей, зате існують одиниці дуже продуктивних авторів. Вище згаданий закон Бредфорда, а також закон експоненціального зростання Прайса, по суті, є також методами наукометрії, хоча вона почала формуватися як галузь значно пізніше. Зокрема, Дерека Солла де Прайса вважають одним із батьків наукометрії. Він написав кілька основоположних монографій, а сьогоднішня доповідь «Велика наука, маленька наука» є алюзією до назви однієї з його праць.

Закон Лотки.

Вже у 50-х роках прозвучала ідея використати алгоритм посилання наукових видань одне на одне – такі дані використовували для створення перших карт науки. Так видання, сильніше поєднані зв’язками взаємних покликів, утворюють певну (тематичну) групу, а загалом з’являється можливість дослідити структуру галузі.

Картографія науки існувала вже тоді, коли приблизно в 60-их роках ХХ століття почався інформаційний бум. З розробкою ефективних алгоритмів пошуку потрібної наукової інформації серед періодики пов'язане ім'я Юджина Ґарфілда. У нього виникла революційна думка: використати принцип наукових цитувань для індексування наукової літератури. Ґарфілд довго виношував цю ідею, а пізніше створив власну фірму, яка згодом стала відомою під назвою «Інститут наукової інформації» – Institute for Scientific Information, ISI. Реферативні видання, що містили метаінформацію про наукові публікації, почали видавати регулярно, а проект став успішним та відомим. З часом Ґарфілд таки знайшов фінансову можливість для організації бази цитувань наукової літератури Science Citation Index, що і нині належить до ядра одного із флагманів наукометричних сервісів – Web of Science.

Приблизно тоді ж, на початку 60-их років ХХ ст., в Радянському Союзі також усвідомили потребу розуміння, прогнозування та організації управління у сфері науки, тому активно здійснювали власні наукознавчі розвідки. Радянський учений В. Налімов опублікував одну із ключових наукометричних робіт під назвою «Наукометрія», тим самим запровадивши сам термін, який потім прижився та був перекладений англійською як «scientometrics».

Механізми опрацювання наукових цитувань запустилися саме тоді, коли були всі передумови: була ідея, почала наповнюватися база даних, потрохи дозрівав математичний апарат – теорія складних мереж, що давала можливість аналізувати дані у вигляді мережі. У рамках згаданої теорії взаємопов’язані дані являють собою ніби набір вузлів, пов’язаних зв’язками. Як вузли, так і зв’язки можуть мати різну інтерпретацію: статті, автори, журнали, країни тощо. Так само різним може бути означення зв’язка: співавторство, цитування, співцитування, належність до однієї організації чи використання однакових тематичних індексів типу УДК тощо. Розроблений інструментарій дає змогу оцінити стан системи в цілому, знайти закономірності серед даних, проаналізувати їхню структуру як статично, так і динамічно.

Наявність даних про цитування у вигляді бази дало змогу проводити активні наукометричні дослідження, а ближче до 70-их років ХХ століття з’явилося розуміння того, що аналіз зібраних даних можна використати для кількісного оцінювання у сфері науки. Оскільки такий інструментарій є надзвичайно затребуваним на практиці, наукометричний напрямок почав розвиватися із новою силою. З часом робилися спроби кількісно оцінити ефективність праці наукового працівника, якість журналу, наукову конкурентоспроможність країни в цілому і так далі. Поступово відбулося певне зміщення пріоритетів, коли завдання інформаційного пошуку, яким первинно мали слугувати цитат-індекси, відійшло на задній план. Практична застосовність таких досліджень спричинила їхній швидкий розвиток та зацікавленість управлінських структур у науці.

З цього часу формування галузі стало інтенсивнішим, був створений власний галузевий міжнародний журнал з одноіменною назвою – «Scientometrics», який досі є флагманом у царині наукометричних досліджень. Ще далі активно розвідували можливості оцінювання науки на різних масштабах, починаючи від індивідуальної публікації чи науковця і завершуючи цілими країнами чи частинами світу. Стали популярними різноманітні рейтинги установ.

2004 року виник конкуретний до Web of Science сервіс – Scopus Elsevier. Невдовзі до відомих раніше індикаторів наукового впливу, що, в основному, експлуатували поняття середнього, з’явився оригінальний індекс – індекс Гірша (а згодом і ціла низка похідних від нього) – що не є ні усередненим, ані абсолютним та поєднує між собою кількість публікацій та їхню цитованість. До слова, зараз в інтернеті можна побачити публікації на кшталт «рейтинг університетів за індексом Гірша», хоча він однаково розраховується для установ з тисячею та сотнею працівників і не передбачає жодної нормалізації. Ті, хто бажає формалізувати наукову працю легким коштом, або кому цікаво оголосити про чергову сенсацію – політики, менеджери чи журналісти – оперують h-індексом, який можна легко вирахувати. Насправді ж таким чином вони ризикують людськими життями і наукою, бо можуть дискредитувати сучасного Айнштайна або ж даремно змарнувати державні гроші.

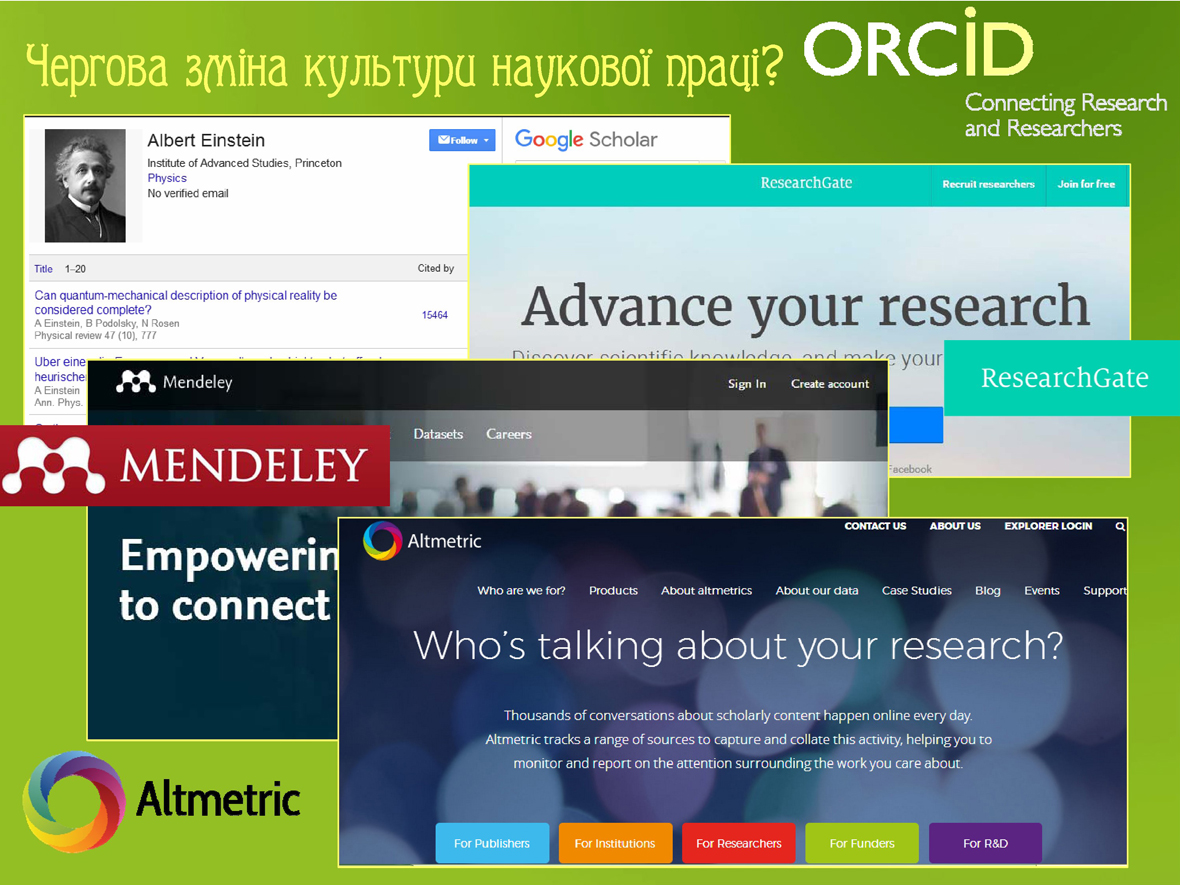

Нарешті, останні тенденції в наукометрії пропонують використовувати не лише цитування, а й інші джерела кількісних даних для завдань «вимірювання науки»: відгуки у блогах, зберігання списків покликів на «улюблені» роботи у спеціальних веб-сервісах, комунікація у спеціалізованих соцмережах та багато інших форм обміну інформацією – все це обумовило народження метрик, альтернативних або ж комплементарних до цитат-метрик, які нині відомі під назвою альтметрики або ж інформетрики.

Цікаво також прослідкувати «дотичність» України до наукометричних досліджень. Ще наприкінці XIX століття радше наукознавцем виступав В. Вернадський, який ініціював комітет з вивчення науки при Академії наук. На початку 60-их рр. ХХ століття у Києві працювала ефективна наукознача група під керівництвом Г. Доброва, чиїм ім’ям нині названо Інститут наукової інформації в Україні. Він пізніше опублікував ще одну ключову монографію під назвою «Наука о науке» та започаткував галузевий збірник «Науковедение и информатика», наступник якого існує і нині під назвою «Наука і наукознавство». 1966 року у Львові відбувся перший радянсько-польський симпозіум з вивчення науки, де, зокрема, виступав і В. Налімов.

Нині існує велика кількість наукометричних сервісів та баз даних, включно з Index Copernicus, РИНЦ (Российский индекс научного цитирования) тощо. Проте найавторитетнішими – власне і через політику жорсткого відбору – є два. Перший, Web of Science, веде свою історію ще від першого індекса Ю. Ґарфілда, заснованого 1964-ого, а з минулого року перебуває у власності компанії Clarivate Analytics. Другий, Scopus, був заснований пізніше компанією Elsevier, що сама є великим міжнародним видавцем наукових журналів.

У кожному випадку маємо справу із ядром – базою даних, що містить бібліографічні відомості і дані про цитування в наукових публікаціях, та аналітичною надбудовою – набором інструментів, які опрацьовують наявні дані та генерують набір готових індексів. Наукометричною можна вважати довільну базу даних, що містить дані відповідного типу. Визначення «наукометричної» не передбачає мінімальних вимог до ширини чи глибини охоплення, також в принципі не обов’язково розробляти власні аналітичні програми. Саме тому нормативні документи, що обумовлюють визначення певного рівня видань чи публікацій, мали б чітко вказувати, яка саме база чи сервіс маються на увазі. Треба додати, що Google Scholar є навіть не базою, а пошуковиком, який супроводжується аналітичними надбудовами: про жодну наукову цінність сама лише видимість через Google Scholar не говорить, а індикатори на основі знайдених покликів будуть відрізнятися (будуть вищими) від тих, що генеруються WoS чи Scopus, тому порівнювати індикатори різного «походження» некоректно. Також, безумовно, про жоден відбір тут не йдеться.

Протягом останніх 50-ти років було запропоновано велику кількість наукометричних індикаторів, які можна розділити на декілька категорій. Так звані абсолютні здійснюють порівняння, не використовуючи жодної нормалізації. При цьому оперують поняттями середньої кількості цитувань з фіксацією публікаційного вікна (час, за який були опубліковані статті) та вікна цитувань (період акумуляції покликів). Відносні індекси застосовують різні процедури нормалізації, щоб передусім нівелювати дисциплінарні відмінності у цитованості.

Є й метрики іншого роду: зважені, що враховують не тільки джерело цитування, а й його власну авторитетність; гірш-подібні тощо. Усі вони розробляються і вдосконалюються наукометричною спільнотою з метою так чи інакше врахувати або хоча б частково компенсувати різні нюанси цитованості: галузеві відмінності; характерні “інкубаційні періоди” (час, необхідний для акумуляції основної кількості покликів); наявність негативних та самоцитувань; вплив різних мотивацій для здійснення посилання; ряд технічних труднощів, пов’язаних зі збором та формалізацією даних, і так далі. Іноді проявляються такі ефекти, як, скажімо, так званий «ефект сплячої красуні». Так називають статті, що залишаються малоцитованими тоді, коли інші публікації відповідної галузі вже набрали показову кількість цитувань, і виявляються в центрі активної уваги лише через сто-двісті років.

Вибираючи, який індекс використати, потрібно чітко уявляти собі завдання дослідження, визначаючи в залежності від цього публікаційне вікно та вікно цитованості. Крім того, є особливості розрахунку кожного конкретного показника, тому дуже важливо правильно підбирати їх для конкретної задачі та не застосовувати як універсальну «панацею» для усіх випадків. Наприклад, один із найвідоміших наукометричних показників, що був запропонований ще Ю. Ґарфілдом та популярність якого завдячує його простоті, – імпакт-фактор видань. Проте і його не припиняють досліджувати та критикувати. Скажімо, сама його суть – це середнє арифметичне, тобто усереднене число цитувань, зібраних для певних статей за певний період. Проте саме поняття середнього втрачає свою цінність для невеликих вибірок даних, адже у таких випадках рідкісні екстремальні значення можуть сильно повпливати на результат. Крім невеликої статистики, є застереження щодо вибору математичної величини, яка б адекватно охарактеризувала те, як насправді цитування розподілені серед статей.

Дискредитація наукометрії, некоректне використання її для принципово важливих рішень у сфері науки обумовили все більше незадоволення вчених. Наприклад, 2012 року в Сан-Франциско було проголошено декларацію щодо оцінювання науки, яка зібрала понад 1200 підписів станом на лютий 2017 року. Невдоволення, висловлене у такій формі, викликало відповідну реакцію від наукометричної спільноти: 2015 року було проголошено так званий Ляйденський маніфест, в якому розписано основні правила використання наукометрики. Адже самі собою показники та індикатори не є неправильними – невідповідними є методи їхнього застосування. Крім того, в наукометричній спільності часто наголошують на важливості комбінованого підходу до оцінювання, зокрема з врахуванням формальних показників та експертної думки.

Маніпуляції з метриками та мірами – це проблема загальна. Відомим є закон Ґудгарда, згідно з яким міра, що стає ціллю, не може бути доброю мірою. Система, яку «вимірюють», починає адаптовуватись та змінюватись так, щоб досягнути найвищих показників, відбувається підміна понять. Подібний сенс має англійський ідіоматичний вираз «ефект кобри». Його вживають для опису ситуації, коли намагання вирішити проблему призводять до ще більшої проблеми. Історія виникнення цього виразу пов’язана з намаганням англійського уряду зменшити кількість кобр в індійських колоніях: було призначено винагороду за кожну вбиту кобру. Проте місцеве населення почало розводити кобр з метою їхнього продажу. Коли ж уряд скасував закон, зрозумівши наслідки, вирощених кобр випустили на волю, ще збільшивши їхню популяцію.

Зокрема, на кожне нормативне нововведення виникає протидія у науковому соціумі. Вимога збільшення кількості публікації призводить до подріблення матеріалу та публікацію його невеликими порціями – так звані «салямі публікації», до взаємного включення у списки авторів, до утворення нових видань як «бізнес-проектів» або ж комерційна пропозиція з опублікування статей. Вимога про публікації у журналах, що індексуються в наукометричних сервісах, викликала хвилю створення всеможливих баз даних, що розраховують індекси. На вимогу якомога більше публікуватись за кордоном зросла частка вітчизняних публікацій у журналах, скажімо, Білорусі чи Казахстану, а не в авторитетних міжнародних виданнях. Висновки можна зробити два: по-перше, потрібно дуже уважно розробляти кожну нову вимогу так, щоб не виникало можливості маніпуляцій. З іншого боку, всі ці приклади яскраво ілюструють вище згаданий закон Ґудгарда, тому варто усвідомити, що немає мір як цілком універсальних, так і незмінних – їх потрібно постійно вдосконалювати та переглядати, калібруючи наукометричну систему.

Тим часом форми наукової праці та комунікації невпинно еволюціонують. Створення google-профілю для кращої презентації себе та своєї роботи; членство у спеціалізованій соцмережі ReserachGate, що пов’язує науковців та повідомляє про останні новини щодо їхньої роботи; використання Mendeley для агрегації «улюблених» покликів та використання чужих списків для пошуку матеріалу; перевірка альтметрик для того, що мати уявлення про популярність тієї чи іншої публікації – всі ці та інші види активності сучасного вченого у мережі Інтернет також пропонують можливість кількісного аналізу та розробки нових метрик.

Триває інформаційна ера, а наукове спілкування переходить на новий рівень. Деякі автори прогнозують, що невдовзі з’являться все нові прецеденти вирішення наукових завдань через «колективний розум», тобто шляхом мозкового штурму та за участі багатьох користувачів. Вже нині публікація в журналі не є єдиною формою представлення наукового продукту: існують бази фрагментів коду, банки хімічних формул, архіви зображень та відеоекспериментів тощо. Науковці знову повертаються до особистого спілкування із використанням блогів та соцмереж. Отже, невдовзі потрібно чекати нового витка і в наукометрії, що адекватним способом мала б відреагувати на зміни в науці.

*****

Доповідь була прочитана на міждисциплінарному семінарі «Обрії науки» 6 квітня 2017 року в Українському католицькому університеті.

Автор – старший науковий співробітник Інституту фізики конденсованих систем НАН України.

Підготувала Соломія Кривенко

02.10.2017